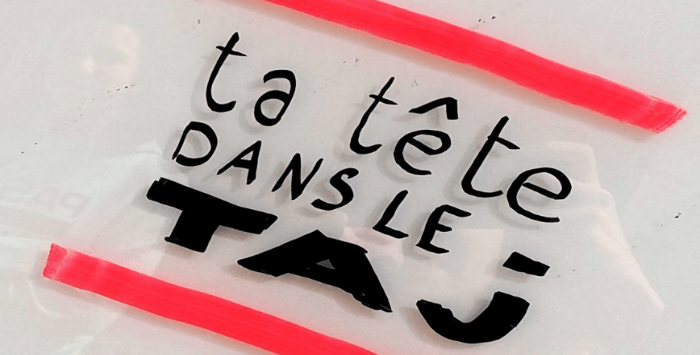

Ta tête dans l'TAJ ?

"Tu connais pas l'TAJ ? Pourtant ta tête est p'tet dedans !"

Le TAJ, fichier de "traitement des antécédents judiciaires", est un méga fichier de police/gendarmerie qui contient plus de 19 millions de fiches, dont plus de 9 millions avec la photo du visage des personnes fichées. Ce fichier concerne les personnes mises en cause dans les enquêtes policières (condamnées ou non), mais aussi les victimes ou les témoins... Au-delà des questions posées par un fichage aussi important, il s'avère que depuis sa création le TAJ sert de façon massive pour de la recherche automatique de visage via des logiciels de reconnaissance faciale. Or le recours massif à cette technologie est interdit par les règles du droit des données personnelles. C'est ce que nous avons voulu faire valoir devant le Conseil d’État dans un recours que nous avions déposé il y a deux ans.

Hélas, le Conseil d’État a rendu son jugement le 26 avril, et, fidèle au rôle qu'il s'est donné de défenseur des politiques de surveillance de masse du gouvernement, il a rejeté nos arguments par un raisonnement absurde.

En gros, pour eux, l'automatisation - via la reconnaissance faciale - serait justifiée, car le TAJ est devenu trop énorme pour être consulté manuellement. Quand une surveillance de masse justifie une autre surveillance de masse...

Le 26 avril 2022, le Conseil d’État a rejeté nos critiques contre l’utilisation massive de la reconnaissance faciale par la police dans le TAJ (« traitement des antécédents judiciaires »). Il s’agit d’une défaite cinglante, qui affirme encore davantage le Conseil d’État dans son rôle de défenseur de la surveillance de masse, sans plus aucune considération pour le respect des droits des personnes. Nous avons l’habitude de perdre et de ne pas nous résigner : trouvons dans cette défaite les futures pistes de notre lutte.

Surveillance massive et illégale

Il y a deux ans, nous attaquions le décret de 2012 qui avait créé le fichier TAJ en fusionnant le STIC, fichier de police, et le JUDEX, fichier de gendarmerie, relatifs aux enquêtes judiciaires et administratives. Il contient des informations à la fois sur les personnes mises en cause (peu importe qu’elles aient été condamnées ou non), sur les témoins et sur les victimes impliquées dans les enquêtes. Le TAJ est aujourd’hui tentaculaire : 19 millions de fiches sont présentes dans ce méga fichier (chiffres de 2018, dont on redoute qu’ils n’aient pu qu’augmenter depuis).

Surtout, et c’était l’objet de notre recours devant le Conseil d’État, le décret TAJ autorise les policiers à utiliser des logiciels de reconnaissance faciale pour consulter sa base de données. Les policiers peuvent automatiquement comparer une image captée par une caméra de surveillance, un téléphone ou sur Internet aux 8 millions de photographies présentes sur les fiches des personnes mises en cause (chiffres de 2018). Cette comparaison a lieu dans le cadre d’enquêtes comme de simples contrôles d’identité, comme l’expliquait le ministre de l’Intérieur en 2021.

Introduit dans le droit en toute discrétion il y a près de 10 ans, à une époque où les outils de reconnaissance faciale n’étaient qu’en gestation, le recours à cette technologie est aujourd’hui généralisé. La police a utilisé le TAJ pour faire de la reconnaissance faciale 375.000 fois en 2019, soit plus de 1000 traitements par jour partout en France (on en parlait notamment dans notre article récapitulatif sur l’état de la reconnaissance faciale en France, ici). En 2020, ce chiffre montait à 1200 interrogations quotidiennes du TAJ par reconnaissance faciale.

L’utilisation massive de cette technologie est pourtant interdite en application des règles du droit des données personnelles. Seules certaines situations exceptionnelles pourraient autoriser un tel traitement et, même dans ces situations exceptionnelles, la police ne pourrait y recourir qu’en cas de « nécessité absolue » – lorsqu’il n’existe absolument aucun autre moyen de poursuivre l’enquête. Nous avons expliqué au Conseil d’État qu’aucun de ces critères n’était jamais rempli en pratique. Rien ne permet de justifier des moyens aussi intrusifs et dangereux.

La fuite en avant du Conseil d’État

Et pourtant, le Conseil d’État a rejeté nos arguments. Il n’a pas nié les innombrables abus que nous lui pointions, mais nous a invité à les soumettre au cas par cas aux autorités (juges et CNIL) chargées d’en vérifier la légalité, plutôt qu’à lui. Comme si le Conseil d’État pouvait se contenter d’examiner la légalité du TAJ de façon abstraite sans se soucier de sa mise en œuvre pratique. Pourtant, justement, en pratique, le Conseil d’État sait très bien que les abus du TAJ sont si nombreux que la CNIL n’aura jamais les moyens de les détecter et de les stopper un à un. Il lui est matériellement impossible de contrôler a posteriori 1000 opérations policières par jour. Présenter le contrôle de la CNIL et des juges comme une garantie suffisante pour pallier ces abus est une échappatoire malhonnête pour permettre le maintien de ces pratiques. C’est le propre de la surveillance de masse que d’échapper à tout encadrement crédible, et c’est cette évidence que le Conseil d’État a niée.

Si le Conseil d’État a refusé de prendre en compte dans sa décision les abus concrets du TAJ, il a quand même cherché à justifier la « nécessité absolue » de la reconnaissance faciale. Sa démonstration est si terrible que nous la restituons telle quelle : « eu égard au nombre de personnes mises en cause enregistrées dans [le TAJ], qui s’élève à plusieurs millions, il est matériellement impossible aux agents compétents de procéder manuellement à une telle comparaison » d’images, dont l’automatisation ne peut dès lors que « s’avérer absolument nécessaire à la recherche des auteurs d’infractions et à la prévention des atteintes à l’ordre public ». Autrement dit, le recours à des logiciels d’analyse d’images automatisée serait rendu nécessaire car le TAJ, abandonné à la police depuis 10 ans et sans aucun contrôle externe, est devenu si tentaculaire et absurde qu’il ne peut plus être exploité à son plein potentiel par des humains. Une surveillance de masse (le fichage généralisé) rend nécessaire une autre surveillance de masse (la reconnaissance faciale généralisée).

Un tel raisonnement circulaire permet au Conseil d’État de se détacher de toute considération quant au respect des libertés fondamentales. À aucun moment il ne saisit l’opportunité d’évaluer sérieusement la seule utilisation connue de la reconnaissance faciale en France, pourtant dénoncée depuis plusieurs années partout en Europe pour les graves dangers qu’elle fait peser sur nos libertés. Au contraire, il sort de son rôle pour n’analyser le fichier que du point de vue de sa potentielle utilité pour la police et ne pas corriger les dégâts causés depuis 10 ans. En abandonnant son rôle de gardien des libertés, le Conseil d’État valide et inscrit dans le marbre la croyance selon laquelle il faut toujours plus en connaître sur la population, considérée comme étant suspecte par défaut.

Prochaine étape de notre lutte

Ne nous décourageons pas et, pour préparer la suite de notre lutte, cherchons les leçons à tirer de cette défaite. Premièrement, il semble risqué d’attaquer la reconnaissance faciale en tant que principe théorique sans aussi s’attaquer à ses réalisations concrètes, à défaut de quoi nos adversaires risquent d’esquiver le débat tel que se l’est ici permis le Conseil d’État.

Deuxièmement, il semble risqué d’attaquer la reconnaissance faciale sans s’attaquer en même temps à l’ensemble du système dont elle fait partie et qui la justifie : le fichage généralisé, dont la démesure a servi de prétexte au Conseil d’État, et la vidéosurveillance qui inonde nos villes et dont la démesure, tout autant scandaleuse, sert aussi de prétexte au déploiement de logiciels de détection automatisée sur les caméras déjà installées (voir notre analyse politique de la VSA).

Notre offensive va donc se poursuivre, affinée et ajustée par ces deux leçons. Cette offensive est d’autant plus urgente que l’Union européenne est en passe d’adopter un règlement sur l’IA qui viendrait légitimer les technologies de surveillances biométriques aujourd’hui interdites par le RGPD (revoir notre analyse) et que la France, actuellement présidente du Conseil de l’UE, fait tout pour défendre son industrie et son idéologie technopolicières.

Nous fêterons bientôt les 4 ans de l’entrée en application du RGPD et des règles européennes de protection des données personnelles, le 25 mai. Si ces règles ont été presque inutiles pour nous protéger de la surveillance des GAFAM, elles ont entièrement failli à nous protéger de la surveillance d’État. Peut-être devrions profiter de cet anniversaire pour essayer de renverser la situation.

Source : Laquadrature.net

Informations complémentaires :

Crashdebug.fr : Ma femme a du crédit (LCP)

Crashdebug.fr : Le « big data » ou la recette secrète du succès d'Emmanuel Macron ?